在vscode中使用本地AI编程大模型

如果您想在您的计算机上运行 AI 代码助手而不泄露信息,甚至不需要互联网连接,现在有相当简单的方法可以做到。

我将在这里展示一个非常直接的解决方案。您需要 ollama、VSCode 和 privy 扩展。

Ollama

Ollama 是一个很好的编排器,可以在本地机器上运行模型。

它支持多个编码器, 本文中我们使用 deepseek-coder.

您可以在 macOS、Linux 和 Windows 上安装它。它可以在 Docker 中运行。

在 Windows 上进行示例安装和验证安装。_

安装 ollama。

使用 ollama 运行 deepseek-coder 模型 :

ollama run deepseek-coder:6.7b

您现在可以在终端上进行聊天。

您可以使用 curl 测试 API

curl http://localhost:11434/api/generate -d ‘{

“model”: “deepseek-coder”,

“prompt”: “How to update deps with poetry”

prompt": "如何使用 poetry 更新依赖项

}’ }'

在vscode中使用ollama

从vs code 插件市场获取privy 。

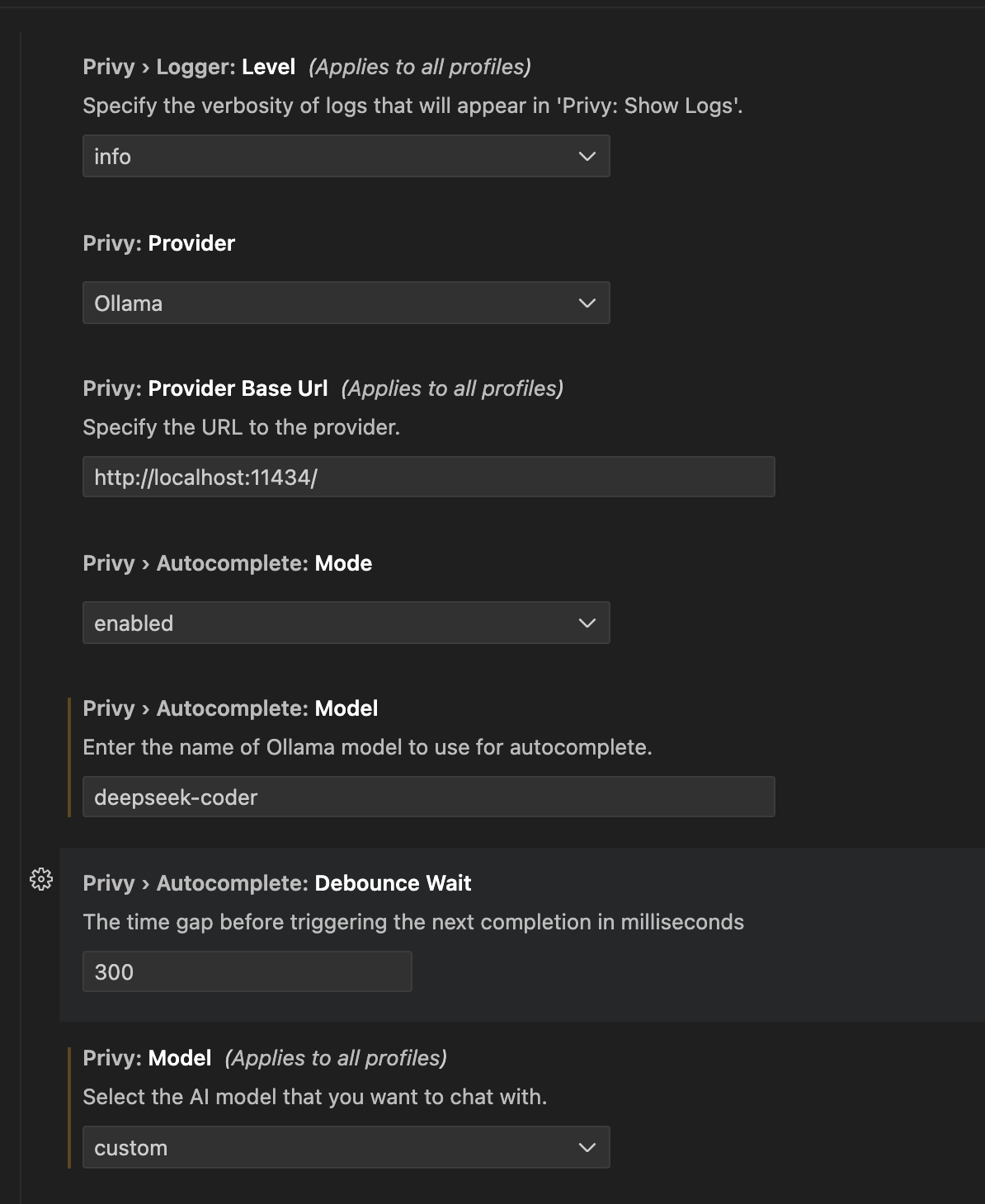

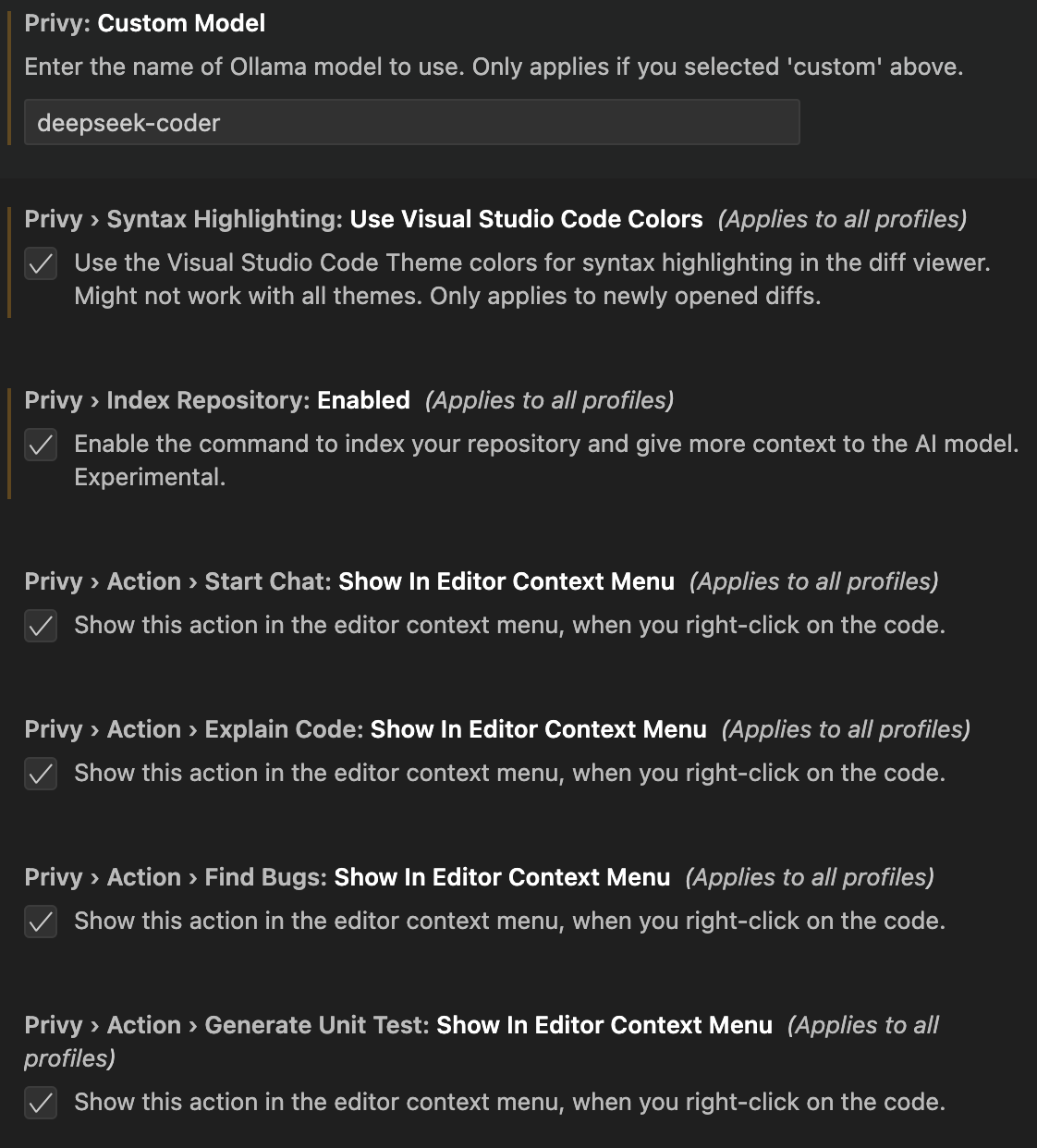

我使用的模型是 deepseek-code,所以我的配置是这样的。

使用这些设置,我可以使用以下功能:

- Generata code 生成代码

- Generate unit tests 生成单元测试

- Diagnose error 诊断错误

- Find bugs 查找错误

- Explain code 解释代码

- Chat 聊天

方法2:通过continue连接Ollama

安装Continue。

在continue的模型选择对话框中,点击"+"。 选择provider为Ollama,模型选择AutoDetect。 添加即可。